Audit SEO de site internet avec Screaming Frog

Dans le domaine du SEO, on dit souvent qu’il existe autant de définition du référencement naturel que de spécialistes.

Et pour cause, comme beaucoup de métier du digital, vous trouverez peu de formations sérieuses dédiées à cette spécialité.

Pour beaucoup, l’apprentissage de compétences en référencement naturel s’acquièrent directement avec ses expériences professionnelles en faisant par soi-même : en créant des sites web, des sites e-commerce, en créant des stratégies de netlinking.

Pour notre audit de site internet, nous allons utiliser le logiciel Sreaming Frog SEO Spider qui permet de réaliser un crawl complet du site (500 en version gratuite) pour récupérer l’ensemble des pages du site web ainsi que les fichiers images, CSS, js …

Cet outil va ensuite nous permettre de réaliser une étude complète de notre site : Audit SEO technique et sémantique.

Nous entrerons profondément dans les détails de l’analyse que va nous fournir Sreaming Frog plus loin.

Avant de commencer le crawl de notre site internet, nous allons configurer le logiciel (menu configuration).

Paramétrer le crawler de Screaming Frog

Nous allons commencer par allouer la quantité de mémoire au logiciel dans configuration / système / allocation de mémoire.

Par défaut, vous trouverez 2 Go, je vous conseille de mettre 8 Go, en fonction de votre machine, cela devrait

être largement suffisant pour la plupart de vos projets.

Rendez-vous ensuite dans Mode de stockage pour choisir l’emplacement des sauvegardes des données.

Dans vitesse, choisissez de limiter le nombre de fil à 3 ou 4 url par seconde.

Dans contenu / doublons, cocher activer les quasi-duplications et choisissez un seuil (par défaut 90%).

Cela va vous permettre de voir les pages dont le contenu est proche.

Dans le paramètre Robots.txt, prenez l’option : «Ignorer le fichier robots.txt, mais signaler le statut».

Cela va vous permettre d’analyser toutes les pages, mêmes celle bloquées pour les robots.

Vous pourrez ainsi visualiser les pages bloquées à l'indexation qui ne le devraient peut-être pas.

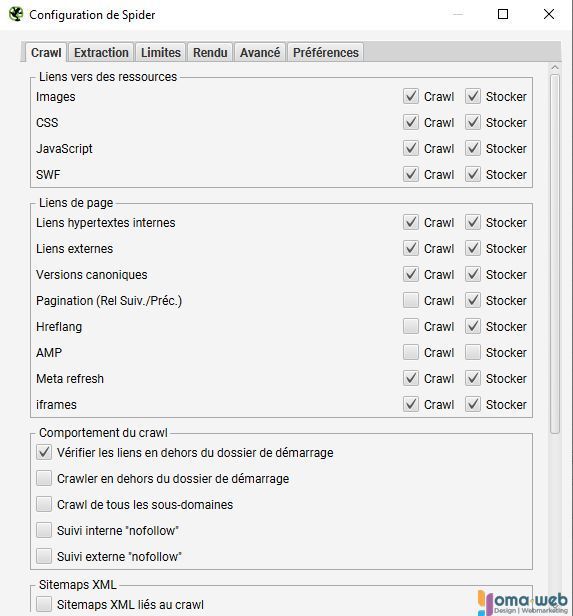

Configurer le crawler

Comme vous pouvez le constater les options sont conséquentes.

La case crawl demande au logiciel de contrôler la réponse de l’élément sélectionné : les images, les fichiers CSS, Javascript…

La case stocker déclare au logiciel s’il doit enregistrer ou non les données dans notre base de donnée.

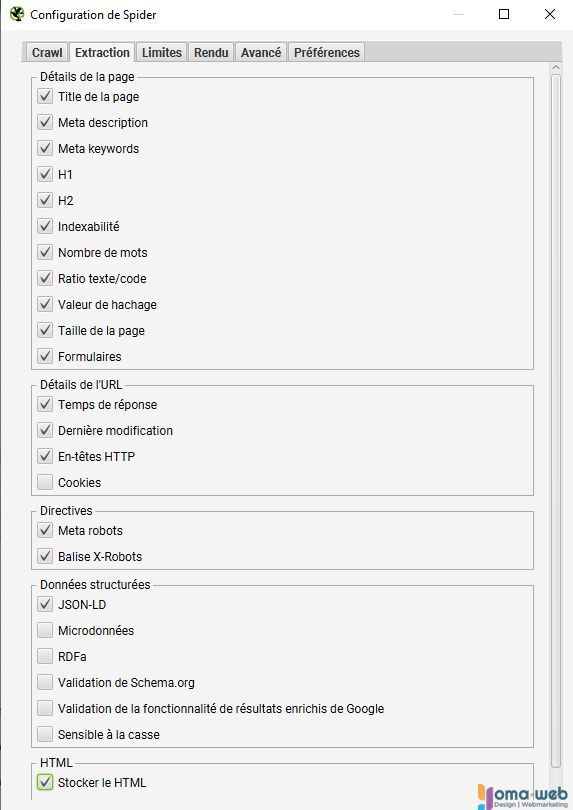

Dans l’onglet Extraction, vous pouvez choisir les éléments concernant la page que le logiciel va vérifier :

- les meta données,

- l’indexabilité de la page,

- le ratio texte / code,

- le poids de la page

- les meta robots

- les données structurées

- …

Il est aussi important de vérifier votre sitemap. Cochez donc "Sitemap XML liés au crawl". Vous pouvez ensuite spécifié le / les liens de vos sitemaps dans "Crawler" ces sitemaps.

Dans l'onglet limites, vous pouvez choisir la d'url à crawler, la profondeur du crawl, le nombre de répertoire, le nombre de redirections à suivre ou encore la taille maximale des pages, ce qui peut être pratique pour les sites très importants.

L'onglet rendu permet de spécifier le rendu du site Html ou Javascript.

L'onglet avancé va vous permettre de paramétrer les cookies, l'extraction des images, le mode HSTS...

Le plus important ici est de laisser le paramètre noindex non coché pour obtenir toutes les pages "non indexables" et ainsi pouvoir les analyser.

Préférences permet d'assigner les valeurs aux éléments de la page : title, meta description, url...

Configurer des API comme Google Analytics

Vous avez la possibilité d'assigner à vos analyses les données rapportées par Google Analytics ou Google Search Console ce qui va vous permettre d'enrichir et peaufiner vos rapports.

Pour connecter vos différents outils SEO (Google Analytics, Google Search Console, Page Speed Insights, Majestics, Ahrefs, Moz), fournissez l'accès à Screaming Frog dans configuration / accès à l'API.

Vous pourrez ainsi agrémenter votre étude de nouvelles données comme le taux de rebond, le nombre de session, leur durée...

Configurer une extraction personnalisée

L'extraction personnalisée permet de révéler des élements html contenu dans vos pages.

Avec cette fonctionnalité, vous pouvez par exemple :

- vérifier que votre code Google Analytics se retrouve bien sur toutes vos pages (UA-XXXXXXXX),

- prélever le nombre de page qui contiennent une expression de mots clés (ex : création de site internet) sur laquelle vous souhaitez positionner votre site.

- extraire une donnée particulière, des h3, h4, hn..., une classe CSS, les social Meta Tags, le hreflang...

Ceci constitue une configuration de base qui sera à adapter en fonction des sites que vous analysez.

Vous êtes désormais paré pour démarrer votre premier crawl.

Interpréter les données de Screaming Frog

Votre premier crawl est terminé, il va falloir vous plonger dans l'analyse.

Pour démarrer notre étude, nous allons nous intéresser à la fenêtre de droite de Screaming Frog : l'overview.

L'avantage de l'overview, c'est qu'il permet très rapidement de visualiser les points à améliorer sur votre site :

- les page orphelines (si vous avez connecté GA)

- l'indexabilité des pages

- les codes HTTP

- la profondeur

- le contenu des pages (h1, h2, hn, les metadonnées, le duplicate content, les balises alt, le nombre de mots et la ratio texte code...)

- le poids des images

- le sitemap

Vous avez un projet Web ?

Profitez de l'expérience d'un expert du

WEB

Je vous accompagne de la création à la stratégie de positionnement de votre site web.